从手机、PC 到汽车,不泄密的 AI 才是时代需要的 AI

任何技术产品都有攻击面,大模型也在所难免。模型产品和攻击方式永远是「道」与「魔」的此消彼长。

比如去年就有份论文提出一个新的攻击方法,成功盗取了其他用户发送给大模型的字段。此漏洞利用了 KV 缓存共享——一项大语言模型 (LLM) 业界广泛应用,两大主流推理框架 SGLang 和 vLLM 都在使用的技术。

LLM 的安全问题不容小觑。无论对于用户还是企业,数据泄露都足以「致命」。APPSO 之前的一篇文章就曾提到,越来越多的人将豆包、DeepSeek 和 ChatGPT 们视作倾诉对象,和它们推心置腹,不经意间便将个人的隐私信息吐露其中。而一旦 LLM 遭遇泄露事故,好事者能够依据数据识别出具体的用户以及对应的现实身份,从而用于不法意图。

为了应对 iPhone 用户使用 AI 产品的隐私顾虑,维持公司数据隐私政策的连贯性,苹果在 24 下半年宣布了一个名叫 Apple PCC(私密云计算 Private Cloud Compute)的系统:

在 Apple Intelligence 场景下,端侧算力不足时,用户数据经私钥加密上传云端,由部署在服务器私密计算模块(类似 iPhone 芯片里的安全隔区)里的大模型进行加密推理,仅在推理过程和结果返回端侧时短暂解密。全链路数据均以密文流转,且采用无状态计算模式,确保数据零存储、用后即焚。

技术是很好,但遗憾由于国内 Apple Intelligence 目前状态微妙,iOS 用户反而用不上。

在 iOS 以外的科技产品世界,另一家公司也正在应对私密云计算的挑战:

火山引擎开发的 Jeddak PCC(私密云计算)平台,有望应用于 Android 手机、PC 电脑、新能源汽车等更多领域,为数十亿用户的 LLM使用隐私保驾护航,企业在加大 LLM 与自身场景结合的同时无需担心数据泄露。

通过在各自的硬件产品和 LLM 技术栈中应用 Jeddak PCC 平台能力,硬件厂商能将保护用户个人数据隐私的承诺,从设备端延伸到云端。

新时代的 LLM 要大,也要安全

近期,火山引擎对外公布了基于 Jeddak PCC,面向私有云 AI 安全推理/私密计算的合作案例,合作伙伴包括联想和努比亚等设备品牌。这也让 Jeddak PCC 成为了国内首个针对个人电脑和智能手机市场布局的私密云计算解决方案。

背景不难理解:日常生活中,每天有大量用户和企业在PC 和智能手机等主流设备上与 LLM 进行互动。联想用户在 PC 上进行文本生成、润色、提炼摘要、深度思考等文本类工作,努比亚用户在手机上使用多模态豆包大模型、扣子空间 Agent(智能体)等产品。

不是所有的 AI 任务都能够在本地完成。一些需要深度思考、知识库建立、以及 Agent 能力的任务,本地模型尺寸太小或算力不够,需要使用云端的 LLM。

问题在于,用户与 LLM 和 Agent 互动,可能涉及机密数据或个人的隐私信息。这就遇到了敏感数据上云的困境了。云端的模型大归大,但服务提供方无法保证安全。当用户处在高敏感、高密级的工作环境中,是不能轻易将资料随便上传给 LLM 的。

PC 和手机厂商对于 AI 产品和服务的架构,需要针对隐私计算的需求进行重构。它们希望构建一个端到端全流程,且能够自证清白的私密云计算平台,用来解决端云协同计算下的 LLM 数据安全隐私问题。

少有其它解决方案,比 Jeddak PCC 更适合解决这个问题。看下面这个典型案例就行了:

假设一个企业科研人员,写了一篇论文准备投稿到顶级期刊,但需要使用 LLM 工具对论文进行润色优化,需要使用外部公司提供的 LLM 工具,同时要求数据全程加密——这是一个典型的检索增强生成(RAG) 任务。

密钥:用户托管一个密钥(BYOK – Bring Your Own Key),PCC 在 LLM 任务的全流程期间使用该密钥进行加/解密。密钥保存在用户设备上 + 云端的安全隔区(TEE 可信执行环境)模块内。

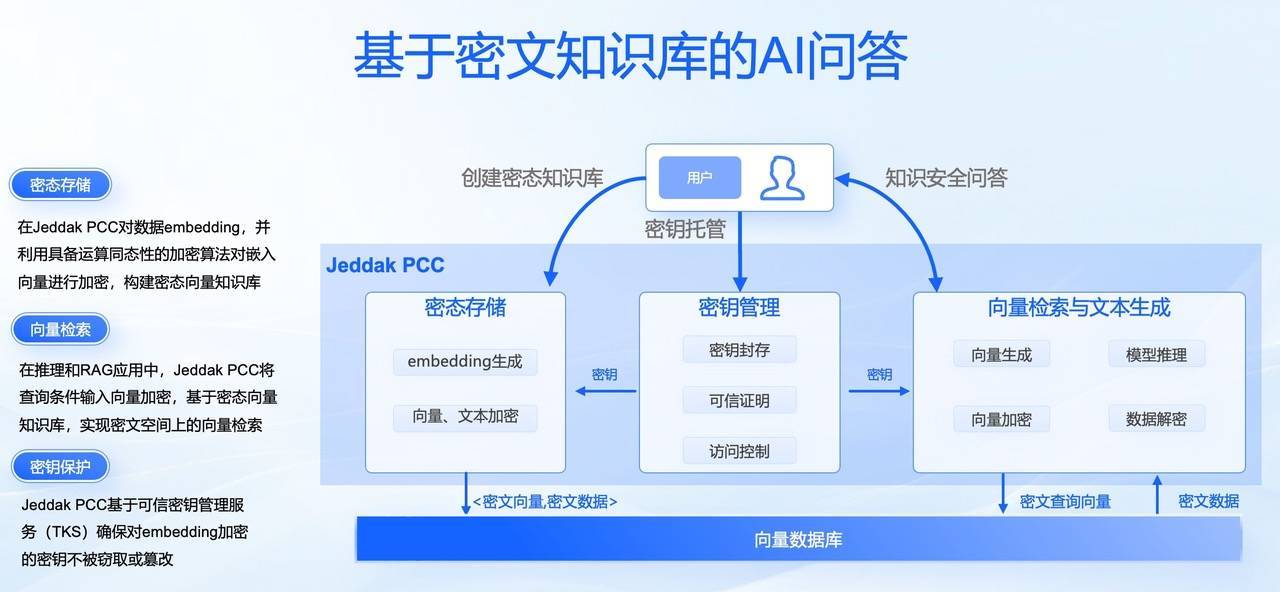

知识库创建:用户上传文档时,PCC提供端云互信的加密通信能力,将用户文档从端侧设备安全地传输到安全隔区内;知识库服务对文档解密、切片,生成明文向量和片段;加密服务将其变成密文向量和密文切片,存储在向量数据库 (VikingDB) 内——密态知识库创建完成。

知识库检索召回:用户对 LLM 输入提示;提示词通过端云互信加密通信传输至安全隔区,在安全隔区内生成并加密明文向量;使用密文向量在数据库检索,召回密文切片;在安全隔区内解密切片后,进行 rerank 等处理。

推理阶段:拼接生成的明文检索结果+用户的提示词,给到大模型(也在安全隔区内)进行推理,生成明文的推理结果——推理完成。

回传阶段:PCC 对生成结果加密,生成密文结果,传回用户设备上;端侧 TEE 的解密服务对结果进行解密,向用户呈现明文结果。

这也正是联想使用 Jeddak PCC 正在做的事情。5 月 7 日,联想正式发布了面向个人和企业用户的超级智能体产品,而火山引擎的私密云计算解决方案成为了这一 Agent 解决方案的基石。

在 RAG 类型工作中,Jeddak PCC 将用户的各类文档进行向量化处理,将硬件芯片级加密安全能力延伸至云端,通过机密计算和密码学等隐私计算手段,实现全流程加密——让用户在构建私人/企业级知识库的时候,无需担心数据泄密。

联想同期发布的多款 PC 设备,包括消费级和商用市场 SKU,均支持 Jeddak PCC 技术。

从整个流程可以看到:

所有涉及到数据流转的过程,全部受到用户粒度密钥的加密保护;

云端只存储密文向量,不存储明文的文本和向量;

只有 LLM 推理使用明文,且推理过程在安全隔区内进行;

LLM 运营商和云计算服务提供商全程不掌握用户密钥,无法看到明文,实现了全程保密。

那么问题也来了:全程加密的方式,对推理效率和用户侧体验是否有影响?

实际上没有可观影响。APPSO 从火山引擎了解到,虽然加密的过程复杂,但从用时的角度,用户不会有明显感知,速度相比明文方式只会慢 5% 或更低。

而从推理结果上,由于采用了高性能的密码学方法,加解密过程的信息很难出现信息损失。LLM 的推理工作在安全隔区进行,没有数据泄密的风险。最后的推理结果无限接近于无损,并且 LLM 仍然保持流式输出的工作方式,让用户可以看到 token 不断生成。

架构开放,业务广泛,Jeddak PCC 已为「Agent 元年」准备好

隐私计算 (privacy/confidential computing) 第一次在大众面前被提起,还是在 2013 年。自从当年的 iPhone 5s,苹果开始在 A 系列处理器内封装一颗单独的隐私计算小模块,名叫安全隔区 (secure enclave),用于生物验证、支付等操作。应用、处理器,乃至整个操作系统,都无法看到这些私密数据对应的明文。

时代更替技术升级,现在每个人都在努力追上 AI 的潮流,享受 LLM、Agent 等技术带来的便利和创新体验。然而隐私计算很长时间以来并没有跟上 AI 普及化的脚步——直到 Jeddak PCC 的问世。

私密云计算的概念,是隐私计算在云时代和 AI 时代的延伸扩展。而 Jeddak PCC 其实就是在用同样的技术,把概念扩展到 AI 云计算的场景下,将存储在用户端侧的私密数据,放在一个更大的区域内做安全的存储、托管和计算。

就像苹果安全隔区让用户首次接触到隐私计算,Jeddak PCC 也是私密云计算的能力第一次交到企业开发者、设备厂商,以及它们的终端用户的手上。而且从架构开放性、支持业务种类、软硬融合等多个方面来看,Jeddak PCC 和苹果 PCC 相比也已经展现出明显的优势。

据 APPSO 的了解,Jeddak PCC 采用开放架构,支持 CPU、GPU 以及异构计算,支持英伟达 Hopper、英特尔 TDX、AMD SEV 等机密算力平台,满足客户的公有/私有云等多种或融合的部署需求。

这让 Jeddak PCC 和苹果 PCC 的封闭架构和完全依赖独家软硬件实现的做法,形成了明显差别。毕竟苹果 PCC 只是为了实现其原生内部应用 (Apple Intelligence) 而推出,而 Jeddak PCC 是火山引擎自研的私密云计算能力输出并普及给整个科技行业。

苹果宣称其 PCC 系统采用封闭架构的一大原因在于确保安全闭环。但其实随着技术和观念的进步,安全行业目前更普遍认为,封闭系统无法减缓「漏洞-入侵-补丁」的亡羊补牢式循环;安全软件在开放的架构和协作的模式中开发,可以确保所有的利益相关者能够及时发现漏洞、补强安全。

这也是为什么 Jeddak PCC 方案的开放架构,可能更容易被行业普遍接受,能够大大加速行业整体安全水位的提升。

火山引擎积累了大量数据库、密码学等方面的人才,这些领域都和私密云计算高度相关。强大的人才储备、安全科研能力,加上一线云服务商的安全政策,可以确保隐患及时发现。

Jeddak 项目组目前在安全方面专利累计达到 130 件,2024 年新增 62 件,涉及密码学、隐私计算、系统安全等专业,覆盖AI、LLM 安全、可信执行环境等技术方向。

除了火山引擎的工作外,开放架构也意味着 Jeddak PCC 的能力和安全性提升也依赖联合端侧厂商客户共同建设。

在支持的 AI 业务类型上,Apple PCC 目前存在唯二目的: 1)服务 Apple Intelligence 产品的用户端体验;2)苹果自己的后端训练,以及公司内部的员工任务。具体能力目前也仅仅涉及推理层面,没有看到对其它 LLM 主流业务类型的支持。

而 Jeddak PCC 已经支持可信 AI 推理和安全 RAG——这两者已经通过前一小节的案例体现。这背后其实是火山引擎隐私计算团队将多年以来在机密计算、同态加密上的技术外放给云服务客户,帮助它们更好在 LLM 安全合规的前提下,实现应用拓展和降本增效。

至于 Jeddak PCC 对 Agent 的支持,更是火山引擎正在加紧研发和测试的业务项目。

业界普遍认为 2025 年是「Agent 元年」,从娱乐休闲到专业任务,各种类型、具备各种能力的的 Agent 层出不穷;火山引擎背后的字节跳动本身也通过豆包、扣子空间等产品深度布局了 Agent 市场。显然 Agent 成为了当下场景可能性最丰富、生命力最强的 AI 产品类别。

火山引擎在6月即将上线基于 Jeddak PCC 的可信版 Agent——OS Agent,让用户通过自然语言指令,即可完成点外卖、订机票等复杂操作,并且任务全过程贯彻 Jeddak PCC 的私密云计算逻辑。随着 Agent 技术的不断进步、市场活跃度提升,Jeddak PCC 也已经为 Agent 的彻底爆发做好了准备。

用户可感知的 AI 安全

无论是触摸屏幕还是输入内容,用户与应用产品的每一次互动都会留下痕迹。而在今天的互联网服务用户权利结构下,一个尴尬的事实是,用户并不真正「拥有」自己的数据。

在 AI 的时代,这个逻辑同样延续。仅就目前的 LLM 产品形态来看,用户的隐私控制权同样极其有限,服务商的隐私政策还未跟上节奏。用户往往在未意识到这一点的前提下,向 LLM 产品发送更多隐私和机密的数据。

火山引擎认为,在这样的背景下,LLM 开发者和云计算平台更需要多做一些努力,帮助国民提高 AI 时代的数据隐私和安全意识。

在 AI 完全起飞,LLM 植入每一个产品的前中后端的新时代,私密云计算技术对于用户的重要性与日俱增。与此同时,这一技术的好处,也应该让用户感知到,给他们可见的获得感。

想象一下,在不远的将来,手机的系统设置-隐私功能里面,会新增一个「AI」模块:

比如,你可以看到自己今天和 AI 进行了 100 次互动,其中有 80 次在本地,20 次发送到云端执行。

不仅如此,你还可以查看每次互动的具体明细,例如时间、输入的提示内容、本地或云端处理。这些细节需要你用指纹、人脸,或者至少输入密码才能查看,因为它们受到手机芯片的安全隔区的保护——本地隔区同样受到 Jeddak PCC 体系的保护。

更进一步,或许你还可以看到那些上云的互动次数,数据在云端被如何加密,用后是否已删除——能够「自证清白」对于一个健全的 PCC 平台来说,是最基本的要求之一。

好的设计,润物细无声。但对于数据隐私安全这种焦点议题,或许让用户能够实际感知到,体验流畅的同时也用得放心,才是真理。

2025 上半年,国内各主流 Android 厂商都在加码 LLM、Agent 相关的功能,创新层出不穷。但与此同时,个人数据隐私的泄露风险在 AI 时代也进一步提高。对于私密云计算技术的需求,也与日俱增。

火山引擎希望 Jeddak PCC 的推出能够满足这些设备厂商和 LLM 开发者的需求,成为 AI 时代全民提升隐私保护和增强安全意识的一个里程碑。

(来源:新浪科技)