光芯片,火力全开

光子学在数据中心人工智能的加速中发挥着越来越重要的作用。

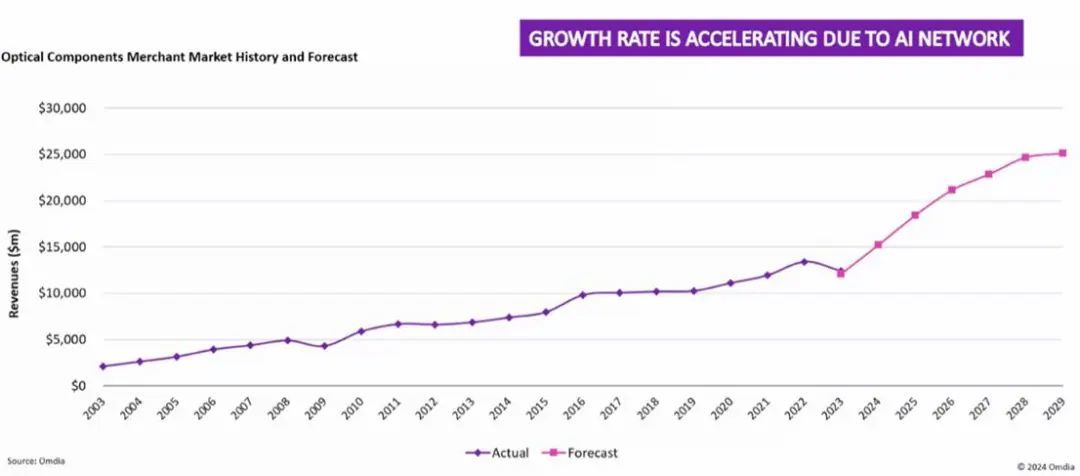

全球光学元件市场规模庞大,去年营收达170亿美元。历史上,电信行业(例如海底电缆和光纤到户)一直是光学元件需求的主导。然而,数据通信领域,尤其是人工智能驱动的数据中心,如今占据了超过60%的市场份额。这种转变正在加速光学技术的发展。

为了跟上AI计算集群(XPU,包括GPU和定制加速器)不断提升的性能,光传输速率正在快速提升。

图1:光学元件市场历史及预测

据摩根大通称,最大的光学元件供应商是相干公司和旭创科技(各占20%的市场份额),其次是博通,占10%。众多规模较小的供应商也在为不断扩大的生态系统做出贡献。

大模型 (LLM) 推动 AI 数据中心增长

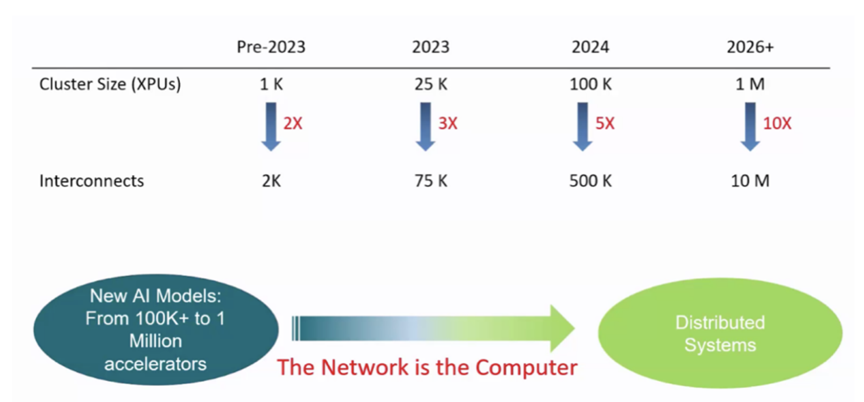

大型语言模型 (LLM) 正在推动 AI 工作负载呈指数级增长。随着 AI 能力的提升和成本的下降,需求也随之激增。LLM 规模的不断扩大需要庞大的 XPU 集群。互连需求的增长速度超过了 XPU 数量本身的增长速度,这迫切需要高带宽、低延迟的网络解决方案。

博通首席执行官 Hock Tan 指出,数据中心的网络成本正在攀升,从目前资本支出的 5% 到 10% 上升到 2030 年预计的 15% 到 20%。

图 2:AI 集群规模呈爆炸式增长

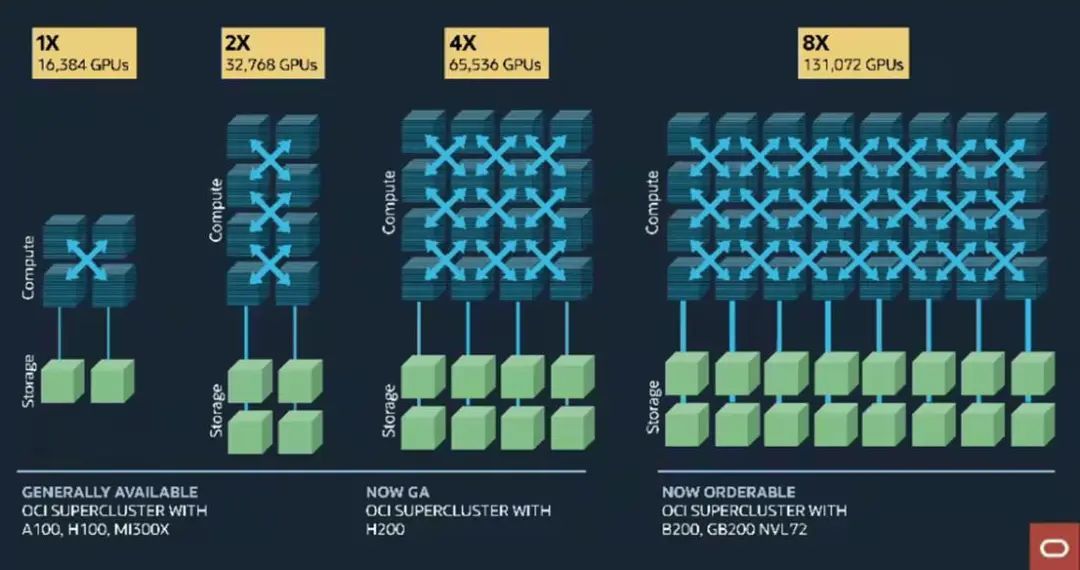

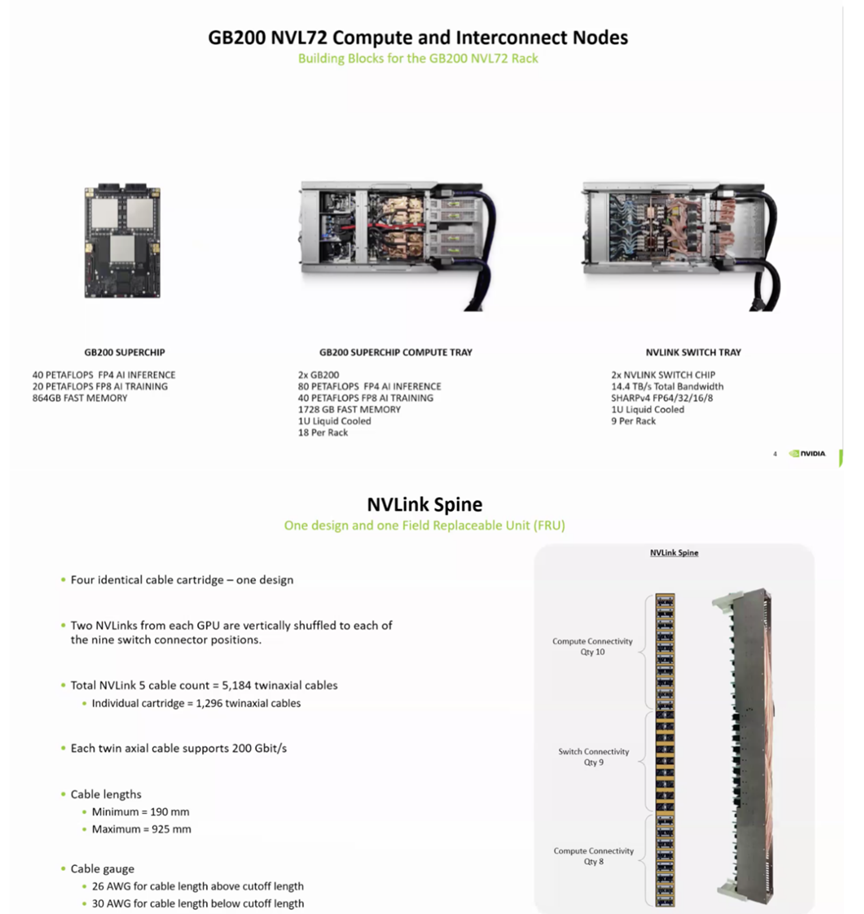

例如,Oracle 云基础设施 (OCI) 正在部署通过 NVLink72 互连的 131,000 个 Nvidia Blackwell GPU 的集群。

图 3:Oracle 云基础设施超级集群产品,助力生成式 AI

横向扩展与纵向扩展网络

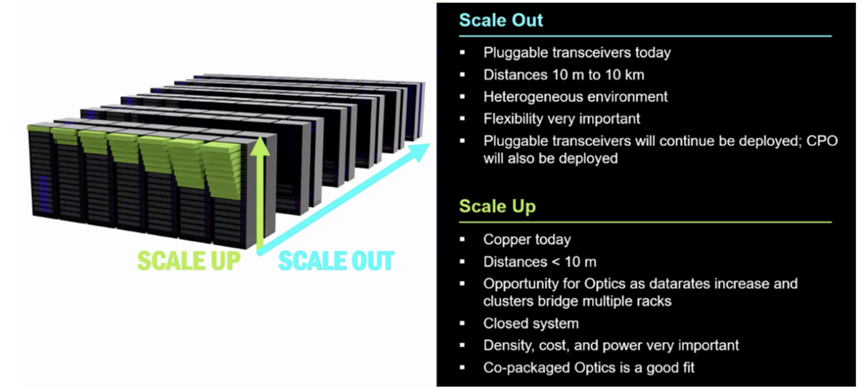

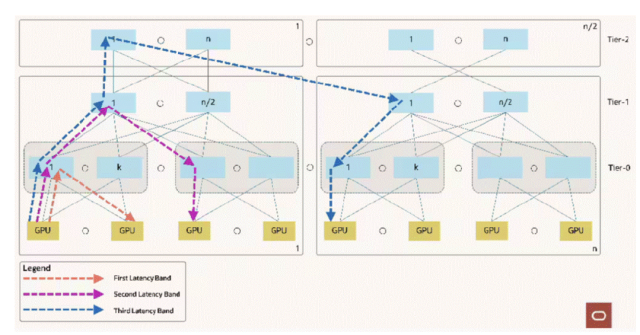

在人工智能数据中心中,互连主要有两种类型:

横向扩展:光纤链路连接跨机架和跨行的交换机

扩大规模:电气链路连接少量机架内和机架之间的 GPU

图 4:数据中心的光学系统

虽然横向扩展网络已经是光学的,但纵向扩展网络向光子学的转变正在进行中,但尚未完成。

横向扩展网络中的光学进步

光子技术是横向扩展架构的核心。如今,可插拔光纤收发器能够实现数十米范围内网卡和交换机之间的数据传输。随着数据速率的提升,这些解决方案面临着越来越大的功耗和性能限制。

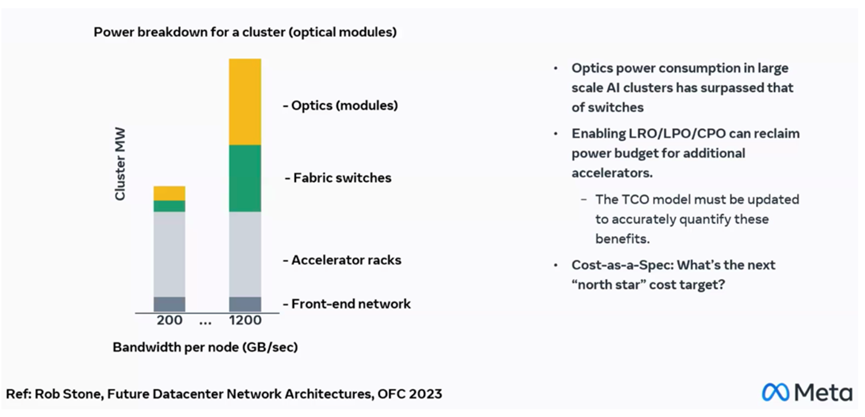

Oracle 的 131K-GPU 架构在其横向扩展网络的三个层级上均使用了光纤链路。然而,传统的可插拔光纤链路功耗巨大。

图 5:Oracle 光纤集群网络结构

图6:功耗和TCO仍然是主要考虑因素

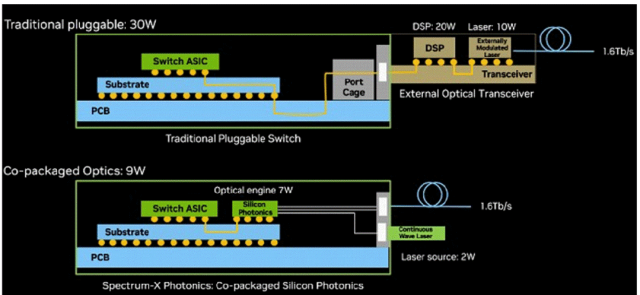

为了满足LLM的增长和吞吐量需求,横向扩展网络中的数据速率不断提升,网络功率已超过加速器机架功率。据Nvidia称,从可插拔光模块转换为CPO(共封装光模块)可以大幅降低1.6Tbps链路的光模块功率,从30W降至9W。

在 GTC25 上,Nvidia 推出了首款搭载 CPO 的横向扩展交换机。其节能特性可实现更高的 GPU 密度——在相同的数据中心功率范围内,GPU 数量最多可增加 3 倍。

图 7:Spectrum-X 光子技术可节省 3.5 倍功耗

可靠性是从铜缆到光纤再到CPO的关键考虑因素。人工智能数据中心的数据量巨大,而且增长速度飞快,就像iPhone一样。从统计数据来看,良率和可靠性必须非常高。谷歌平台光学总监表示,每天0.004%的链路故障率听起来不错,但对于100万条链路来说,这意味着每天有40条链路故障。光学解决方案需要设计成极低的故障率,并在非常苛刻的条件下进行测试,并使用非常大的样本量,以确保量产成功。

扩大网络中 CPO 之路

目前,纵向扩展互连仍以铜线为主。Nvidia 的 Blackwell 架构采用全铜解决方案 NVLink72,其广泛的布线贯穿了主板、交换机和机架背板。如今信号频率极高,铜线束可以直接连接到 GPU,从而绕过传统的 PCB 走线。

图 8:Nvidia 的路线图已延伸至 NVLink576,该线路仍使用铜缆,但不断提升的数据速率和信号完整性问题最终将需要采用光纤解决方案

然而,铜缆的局限性正日益凸显。Nvidia 的路线图已延伸至 NVLink576,该线路仍然使用铜缆,但不断增长的数据速率和信号完整性问题最终将需要光纤解决方案。

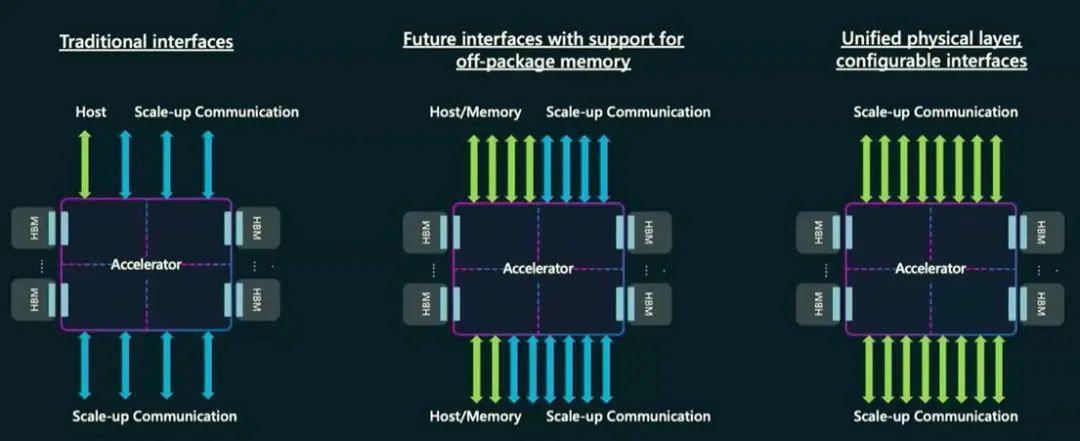

微软提出了对未来AI加速器的CPO要求,希望用一个具有可配置接口的单一物理层来取代现有的接口。

图9:新的互连场景需要统一接口,并具有更严格的延迟和可靠性要求

新的统一接口需要“兼顾两者”——合并后的规范比它们所取代的传统接口更好。这给CPO带来了更大的挑战,但同时也扩大了市场。

图10:新的统一界面需要比它所取代的传统界面更好

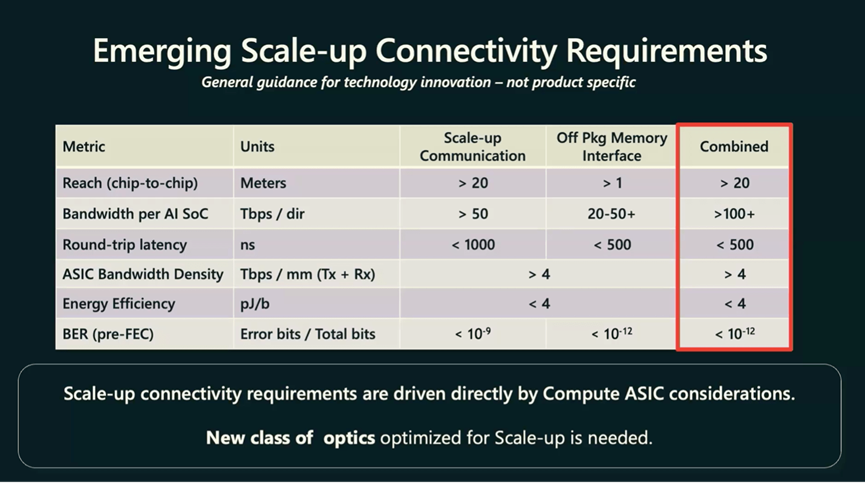

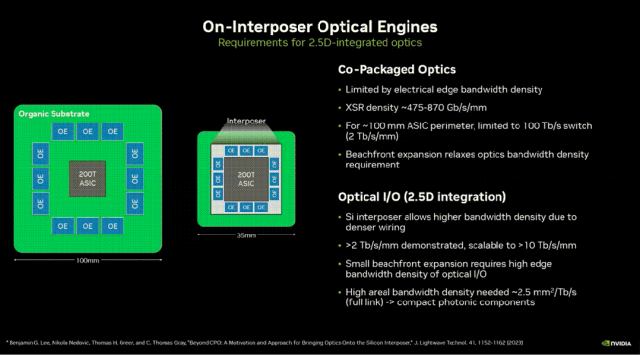

Nvidia 还提出了对 CPO 与 AI 加速器集成的要求:

图 11:Nvidia 的 CPO 要求

这些要求虽然具有挑战性,但切实可行。Needham & Company 建议,在 Scale-Up 网络中,CPO 的初步迁移将发生在单个 GPU 域内的机架之间,而机架内连接暂时仍采用铜缆连接。

100% 的数据中心 AI 芯片均由台积电制造。他们深度参与所有主要 AI 厂商的技术路线图:他们只开发主要客户所需的产品。台积电在 4 月底的年度技术大会上展示了其 AI 芯片路线图,其中包括共封装光学器件:他们预见到了这一趋势,并正在为此做好准备。

市场前景和行业参与者

预计未来几年内,规模化网络将开始向 CPO 过渡,并在 2030 年代大规模替换可插拔式光模块。到 2030 年,CPO 市场规模将从目前的零增长到 50 亿美元。博通、Marvell、Ayar Labs、Celestial AI 和 Lightmatter 等早期进入者以及 Coherent 等激光器供应商都将从中受益。

图12:光学元件快速发展,CPO将在2027-2030年出现

光子学不再仅仅赋能人工智能,它正成为人工智能规模化发展中不可或缺的一部分。到2030年代中期,所有互连都将是光学的,并且都将采用CPO。

参考链接

(来源:新浪科技)