这个AI试衣功能,治好了我的冲动消费

每一次网购衣服,都是对自我认知的一次刷新。这不是最近 618 大促吗,再次印证了那句“老话”——看买家秀以为是东方不败,到手一穿像衰神二代。

更别提尺码合不合适了。谁知道我鼓起多大勇气给客服报上身高体重,可每每都得不到准确建议,“亲,还得偏大一丢丢哦。”算了算了,再多买件XL的吧......

最烦的是退货。换个角度想想,店家也心累啊。七天无理由退货政策,让许多买家钻空子,把淘宝店当试衣间,拍完照就退货。反而是我们这些永远网购不到合适衣服的人,生怕被店家拉黑。

AI 这不是越来越能耐了吗,我之前在 GitHub 玩过几个“AI 换装”工具。上传一张自己的照片和黄裙子图片,静待几秒,满怀欣喜地得到了一张“黄色大菠萝”......

不过最近我在 Google I/O 上看到,Google 针对电商购物,推出了一个“Try On(试穿)”AI 功能。

效果终于有点 AI 量体裁缝的意思了。

“剁手党”福音

衣服版型就像菜谱,身材就像食材。模特图好看,线条顺滑,垂感在线,那是因为按着菜谱买对了食材。

可是普通人高矮胖瘦,身材各异,是直角肩还是溜肩,胸背宽还是窄、腰线高不高,这些身体细节都会影响衣服穿出来的效果。

同样一套衣服,瘦人穿上显清爽,壮人显厚重。

所以最让我惊艳的是这个功能会把衣服版型穿在你身上合不合适展示出来。

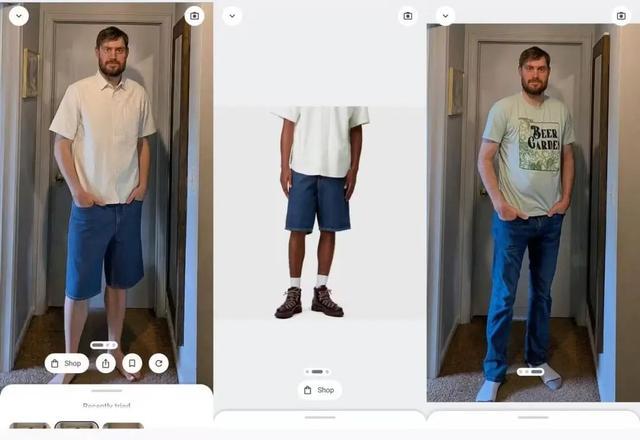

你们猜以下这组图片,哪张是实拍,哪张是AI合成的?

答案:都是合成的。

深色显瘦,白色显胖,啤酒肚的鼓起,手揣兜带来的衣服下摆褶皱,都很自然。

这么说吧,感觉我能用它生成的照片去小红书上做优衣库穿搭博主了。

How To Geek 的记者在 Try On 后,吓了一跳,他说“我上传的图片是穿长裤,结果试穿短裤,居然把我的小腿露出来了。我发誓,和我自己小腿一模一样,说实话,让我有点儿怕。”

左:试穿后 右:原图|图源:How To Geek

“这是我第一次觉得 AI 试衣服不是个噱头。”来自科技博主 @MKBHD。

可惜 Try On 这功能才开放内测,仅限于美区 IP+美区 Google 账户去申请 SearchLabs 后解锁。

它生成的实际效果不同于之前“换装贴图”的工具,原因很简单,P 图是现有图层之间的堆叠,而 Try On 是从头生成一张全新图层。

AI 高定裁缝

我扒了扒 Try On 背后的技术细节,

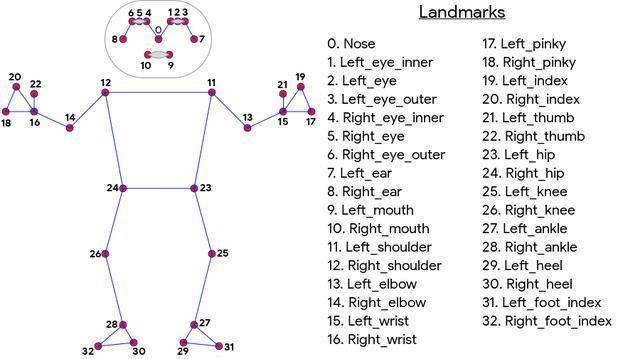

第一步,人像识别:

首先,依赖高精度分割模型建立一个准确的“人像轮廓模型”,其多尺度语义分割技术(multi-scale semantic segmentation)来识别发丝、耳朵、手指间隙、腿部走向、服装遮挡区......所以哪怕你披头散发,戴着耳环、手持手机,AI 都会测算出边界,保留在后续生成里。

第二步,生成式AI:

Try On 对比其他类似工具生成的模拟图除了真实,还有一点,是立体的。不仅能看到正面,还能看到侧面、微微转身的角度。

这说明,光是把底图里的人“抠”出来还不够。

AI 还得分析人的肩宽、胸围、腰围、体态、站姿,照片光线射入角度……做人像建模(body modeling),这部分基于 Google 自研的 Vision AI 模型和 pose estimation 模型。

动补也是这个原理|图源:Google

这就是为什么没露小腿,AI 也能根据对身材的建模,算出来“小腿应该长啥样”。

同时,模型接收服饰图片中的信息,比如布料是什么质感、衣服有多少层、版型修身还是oversize......

通过交叉注意力机制,把两张图片信息融合,用扩散模型生成身着新衣的图片。

我们知道知识图谱是传统谷歌搜索的“大脑”,存储着用来回答用户查询的所有信息。购物图谱(Shopping Graph)是其中关于购物意图和产品信息提供的一个分支。

基于 Shopping Graph 中海量数据库,训练模型识别在各种体型、肤色和姿势下的穿着效果,从而提高了模型的泛化能力。

不同身材的试穿图作为基础数据|图源:Google

但试妆到这一步还是略为“粗糙”,好似你在服装店,拿起衣服站在镜子前比划。穿上到底合不合身呢?

第三步:图像合成

Google 用了图像对齐和 pose-aware warping 网络,让服装与人体姿势对齐。比如你插兜、弯腰、举手,AI 就可以让衣服在这些动作下自然变形,比如膝盖处鼓起一点,衣角飘起来,举手肩膀处有褶皱。

先把本来的衣服建模,再通过 3D 渲染「换皮」|图源:Google

一些“难点区域”会着重处理,交叉注意力机制会判断披肩长发和衣服如何自然衔接,“头发和领子谁在前”。

再比如,底图中人身着深色内搭,想试穿一件半透明防晒服,“动态分层贴图”技术会自动调整衣服的视觉层级,确保防晒服图层在视觉上正确地覆盖在衬衫图层之上,保证光影、纹理、透明度都协调。

还有光照匹配,让新衣光感匹配底图中的光源。

不过现在这技术还“挑”衣服,远没到万能衣柜的程度。

目前它最擅长的是贴身、版型明确的上装,比如 T 恤、衬衫、针织衫,底图中人物也最好是正面站直、手别乱动、光线别太飘。这时候 AI 才能安心建模,不出纰漏。

版型过于松垮复杂,衣服叠穿好几件,那 AI 就容易抓瞎。以及还不支持帽子、眼镜、鞋子这些配饰,这不难理解,这些配饰的遮挡处理起来复杂。

动态试衣也还不支持——还没法像《模拟人生》试衣间里似的,转个圈,走两步,试个坐姿效果。

这技术在 1995 年电影里就出现了?|图源:《独领风骚》

比网购真实,比逛街舒服

更重要的是,Try On 还可能催生一整套“服装体验链”。

比如,你在试穿一件古巴领衬衫时,它会给你搭配一条细细的金色项链、一双白色球鞋加一块皮质腕表。这不一套“热带 OOTD”就有了。

再往前看,静态的试衣还能发展成动态的,带上头显进入虚拟试衣间,直接颠覆网购体验。

要不说,这也是对商家的利好。退货率,本来就是服装电商最头疼的问题,一件衣服从出库到回仓,来回折腾物流、包装、人力成本,还影响商品周转效率。

Google 还演示了一个场景。看起来 AI 对电商的重塑,绝不会只有试衣服这么简单。

现在,我们在电商购物时还是得在搜索框里输入“羊绒地毯”或是“客厅简约风地毯”等关键词。

但在未来,你可以写“我有一个浅灰色的沙发,想买一个搭配的地毯,能让房间看起来更明亮。我有四个小孩,我们喜欢一起在沙发附近玩乐,但家里有猫,不想让猫把地毯抓花。”这类非常具体的需求,AI 就可以在成千上万个商品里找到最符合你需求的那几个。

左侧是用户提的特别明确地需求,右侧是推荐产品|图源:Google

推荐算法的逻辑是“猜你想要”,而 AI 最终目的,是精确筛选,帮人节省时间,提升效率。

脑洞开完还得回归现实,目前这项新功能已经有技术滥用的苗头了。

有人给美国副总统 J·D·万斯穿女装,让“红脖子“变”女装大佬”。还有人拿未成年人照片去换上暴露的服装。

画风是这样式的丨大西洋月刊

也就是说,不需经过本人同意,就可以拿着我的照片,给我“套上”一件不想穿的衣服。在穿衣自由的时代,穿衣反而不“自”由了。想想这还挺可怕的......

(来源:新浪科技)