对话CMU李磊:好的AI学者绝不只搞“纯学术”,大厂AI Lab请集中资源干大事

李磊总是出现在某股浪潮的开端。

2002年,在拿下中国高校第一个ACM(计算机领域最顶尖的程序设计大赛)金牌后,上海交大设立了“ACM班”,这个用最高竞赛命名的班级后来人尽皆知,成为中国AI人才的重要阵地。

也在那年,李磊成为ACM班第一届的学生。在ACM班他第一次意识到,“原来计算机能帮助解决人类的这么多问题。”

尽管从ACM走出的AI公司企业家不少,但继续钻研学术是创办者俞勇对这个实验班弟子们寄托的执念。2024年斯隆奖获得者杨笛一, TVM、XGBoost作者、卡内基梅隆大学助理教授陈天奇,关注度极高的年轻学者纽约大学助理教授谢赛宁等都从这里走出。

不过,在过去十年里,工业界和学术界的边界随着AI技术演进的夸张速度而变得模糊。

2014年,在深度学习被科技公司们率先看到潜力后,李磊加入当时的百度美国研究院,这个研究院在此之前刚刚差点把Geoffrey Hinton招入麾下。而一股科技公司创立AI实验室的浪潮也正式开启。两年后,李磊加入年轻的字节跳动,参与创立了字节的AI实验室。这些组织继续一路演变为今天大模型竞争里的最主要玩家。

2021年,李磊离开工业界。也在那一年他参与的《Vocabulary Learning via Optimal Transport for Neural Machine Translation》拿下自然语言处理(NLP)领域顶级学术会议 ACL的最佳论文。现在他回到了读博士的母校卡耐基梅隆大学(CMU),在著名的LTI(语言技术研究所)担任助理教授。这里被称为AI研究天花板和殿堂级的研究机构,走出一众知名学者。

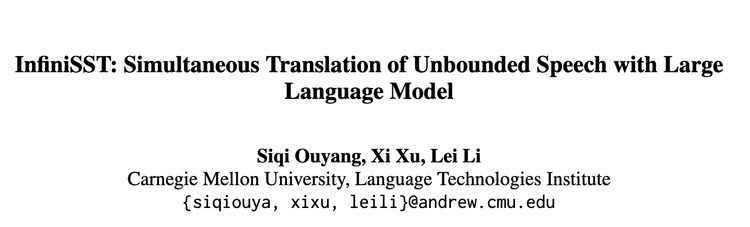

随着LLM(大语言模型)因ChatGPT而彻底成为今天最收敛的技术路线,许多过往一直在挑战的任务有了新的解法。李磊的研究方向之一,就是语言翻译任务。在最近的一篇李磊自己很重视的论文里,他和团队把LLM的许多思路用在处理实时同传上,将翻译视为一个类似与ChatGPT聊天对话的任务,从而通过架构等技术创新实现了“无限”长度的实时翻译。

这篇论文名为《InfiniSST: Simultaneous Translation of Unbounded Speech with Large Language Model》,也已经被ACL收录。在它的概要中它这样写道:

“我们提出了一种名为 InfiniSST 的新方法。该方法将语音到文本翻译(SST)构建为一个多轮对话任务,从而实现了对不间断语音的无缝翻译。我们在训练过程中,利用 MuST-C 数据集构建了翻译轨迹和鲁棒的语音片段,并辅以多延迟增强技术。同时,我们还开发了一种键值(KV)缓存管理策略,以支持高效的推理过程。在 MuST-C 的英语-西班牙语、英语-德语和英语-中文数据集上进行的实验表明,与基线模型相比,InfiniSST 在保持相同翻译质量的同时,将计算感知延迟降低了0.5到1秒。”

最近我有机会在加州湾区和李磊做了一次对话,聊了聊他最新的研究、今天学术界在关注的技术方向,他对今天LLM大行其道的想法,以及他对工业界与学术界关系的思考。

以下为对话实录。

把同传理解成一个跟ChatGPT聊天的过程,然后实现流式的持续实时翻译

硅星人: 先来介绍一下您最新的这个研究吧。

李磊:好的。我们的研究是这样的。首先,语音同传这个领域其实已经发展了比较长的时间,过去20年一直在做。整个核心目标是希望达到非常高的翻译质量,并且能够实时。准确和实时这两个要求同时满足就非常困难。

我们所说的实时同传,是希望延迟非常非常小,小到你几乎感觉不到。一般人一句话大约是10到20个词,耗时5到10秒。如果我们要等10秒,这个延迟是能明显感觉到的。但如果我们能把延迟控制在一秒以内,也就是说,在说话人讲出两三个词之后,我们就能立刻翻译出来,并且质量非常高,这就非常有用了。所以,我们做的是能够将实时延迟控制在一到两秒之内,并且翻译质量非常高,几乎接近离线翻译的质量。

硅星人: 就是同传的方式,达到接近交传的质量。

李磊: 这个就是目标。当然,过去五年,大家的技术一直想做到这一点,但都还没有完全做到。

硅星人: 也不光是过去五年,我感觉很早就开始有这个想法了。

李磊: 没错,一直都在做。但是之前的技术很难同时做到实时并且质量非常高。我们新的这篇论文 InfiniSST,首先结合了语音和文本两个模态各自的预训练模型。这两个模型本身已经预训练好了,所以我们有一个基于大量数据预训练好的语音模型,还有一个基于 LLaMA 或 DeepSeek这样的大语言模型。

硅星人: 这次选的是 LLaMA?

李磊: 对。但我们也可以接入别的模型,技术上是共通的。关键是找到一个预训练好的模型。这样一来,它生成文本的能力和语音作为输入的能力都比较强。但是,如果只是简单地把这两个模型拼接起来,是无法完成从语音到文本的翻译任务的。

硅星人: 大家比较了解预训练的语言模型,那预训练的语音模型是怎样的?

李磊: 预训练的语音模型现在也有非常好的,比如以Wave2vec为代表的一类模型,就是比较好的一个例子。它的核心想法是用Transformer Encoder这种架构,直接对输入的语音进行处理,输出就是一个嵌入。当然,它的训练是需要预训练的,这个预训练里面有各种技术,包括用对比学习 (contrastive training) 的方法,也包括用一些编译 (compilation) 的方法去做,这些技术也都用上了。

它的一个缺陷在于,这种架构因为是Encoder架构,所以它是双向的,只能做离线 (offline) 处理。也就是说,我需要一段话全部输入完成之后,才能一次性处理。它不能做增量式的、流式的处理。所以,为了适应这种实时语音翻译的需求,我们需要在预训练模型的基础上做修改,然后再进行一些额外的训练,把它改造成适合我们做流式翻译的模型。

硅星人: 简单拼接起来不够,要两个模态的融合。

李磊: 没错。我们的模型最核心的有几个创新点。第一,我们能够实现语音到文本的转换,并且语音是源语言,文本是目标语言。我们能够做到这种跨模态、跨语言的转换和翻译,把整个流程连接起来,保证了翻译的高质量。

第二个创新点是实时性。实时要怎么做呢?因为在计算的时候,我们不能等一段完整的输入都接收完毕。我们必须做到,进来一段声音,哪怕只有一秒钟,甚至几十毫秒,就要立刻进行计算。每一个几十毫秒都要不断地计算。我们开发了流式计算技术,使得它能够流式地、并且非常快速地进行计算。

第三个随之而来的挑战是,人在讲话的时候,内容可能会非常非常长。因为是实时翻译,讲话可能不会停顿,可能会持续十分钟,甚至像我们现在开会讨论,可能长达一个小时。这么长的内容都需要翻译出来。作为输入,这个序列会变得非常非常长。我们还专门针对这种长输入做了长上下文 (long context) 处理技术。这三个创新点结合起来,最终我们实现了这种实时的高质量翻译。

硅星人: 我昨天仔细看了论文,你们提到了其他一些以前的工作,和这次的区别好像在于他们用的是segment(分段)的方法,而你们现在是要做infinite(无限的)。

李磊: 对,我们叫 InfiniSST 的原因就是要做非常非常长的上下文。

硅星人: 所以刚才您说的那三个关键点,就是这次用来解决这个问题的创新的地方。

李磊: 是的,要解决非常长的这种流式语音输入的实时高质量翻译问题。

硅星人: 语言模型和语音模型两个领域的融合,那您认为这到底算是一个SST的新方法,还是LLM解决了一个新问题?

李磊: 它不是解决LLM内部的新问题,而是解决了跨模态——从语音到文本这种跨模态大模型生成的问题。因为传统的LLM主要是处理文本,我们这里还涉及到语音到文本的跨模态问题,并且是长上下文。

硅星人: 现在大家经常看到几家公司,尤其是Google讲多模态讲得比较多,但他们主要涉及文本和图片。

李磊: 我们的多模态要处理语音。

硅星人: 那你们这个算不算最近很多人在说的,一种端到端的方法?

李磊: 我们就是端到端的。所谓的端到端和级联 (cascaded) 模型的区别在于,是用一个模型来解决问题,还是分步骤来解决;是解码一次还是解码两次。我们现在只需要解码一次。

硅星人: 就是前面提到的那两个模态的模型变成一体的了?

李磊: 是一体的。我们整个是一个统一的模型,只需要最后做一遍解码,不需要做两遍。如果是级联模型,它需要做两遍解码。

硅星人: 这里面您觉得,在提到的那几个创新点里,比较难的地方在哪里?

李磊: 技术难点也是刚才的三个点。一是跨模态如何融合。因为语音模型出来的嵌入 (embedding) 不是LLM想要的,不是LLaMA想要的。LLaMA需要的是文本的嵌入,但语音出来的嵌入是另一种形式,这两者怎么匹配起来?

二是,我们这个模型,它原来的预训练语音模型,并不是为增量式计算设计的,它不能做这种增量式的流式计算。我们对模型架构做了改变,让它能够进行这种增量流式计算。

三是,在这种情况下,如果上下文非常非常长,我们怎么样让它能够处理这种长上下文,并且在开始给它一个指令后,它不会忘记这个指令。

硅星人: 刚才我提到那个问题,到底是一个SST的新方法,还是LLM又解决了一个新问题,就是因为这三个创意都很容易让人联想到LLM里面的一些技术,比如Transformer里的Attention机制,包括看你们论文里用到一些移动窗口之类的,而且是LLM做长上下文处理的那些技术。

李磊: 没错。LLM里面处理长上下文的技术,在这里面都有用到的。当然,我们针对同传做了一些特殊的设计,针对性的设计。整个这三个方面的架构都有重新设计。

硅星人: 所以这让我有两个好奇。一个是,我也跟很多人聊过,尤其是一直在做语音的研究者,您刚才也提到这个领域有20年的历史了。在LLM这么火之前,大家可能是在研究语音本身的一些技术的突破,而今天的方法都在向语言模型靠拢,就因为LLM今天太强大了。比如像您刚才提到的,语音识别出来的embedding不是LLM想要的,难道这个就必须得是它想要的?

李磊: 那么我们就要讲,在这之前大家用什么方法。在这之前,我们组包括整个学术界其实都在探索,无论是离线的还是实时的同传模型。这种模型一般是基于Transformer Decoder这种架构,单独训练的。这种模型在一定的、有限的领域内能够做得很好,比如在中英文这种数据量比较大的语向上,它可以做得比较好。但是,它对于口语化的内容,翻译效果还是不如LLM,尤其是LLM加上一些双语数据进行微调之后,LLM可以做得更强。

那么这就很自然地引出一个结论:我们要把效果做得更好,就要用LLM,而且一定是需要预训练的模型。之前是没有预训练模型的,现在的一个重要启示就是,我们一定要用预训练的模型。文本要用LLM,语音也要用预训练的语音模型,这两者都重要。但是,当你把预训练的大模型结合起来去做的时候,如果只是简单拼接,你会发现它非常非常慢,不适合用来做实时语音同传,因为实时同传对性能要求很高。这个时候,你就需要对模型结构、训练方法以及整个推理 (inference) 的处理过程进行优化,才能够达到比较高的质量,同时延迟又非常低。

所以我们用了很多LLM的思路。它们其实就是一个语音家庭 (speech family),所以本质上LLM里面用得成功的技术,我们当然都会借鉴过来。

硅星人: 另一个好奇是,刚才我们强调的长上下文,感觉对于LLM这种热度不停变化的领域,它是上一个阶段比较热的一个讨论话题了。然后现在像R1和o3出来以后,推理是今天最重要的能力,这部分是不是也可以用在这里?比如我在想,我去做同传的时候,我会一边听一边猜测对方大概要说什么,甚至不只是您说的流式处理,不只是等对方说两三个词我才开始想,而是我甚至能想到他后面可能要说的内容。

李磊: 你说的这个问题非常好。首先这里有两个问题。一个是说推理能不能用上。我觉得这个非常值得研究,我们目前这个研究里还没有用到,但是我觉得后面我们可能很快会看到相关的进展。然后你还说到了另外一个问题,就是人在说话的时候,可能只说了半句,后面半句还没说,但是我们是不是可能预测出来?我们今年另外一篇论文,刚刚被NAACL录用的,叫TAF (Translation with Anticipating Future),就是做这个预测的。当我要做翻译的时候,你前面中文这句话只说了半句,还有半句没说,我先去预测你后面半句可能是什么。如果我的置信度非常高,我非常确信你有可能说出这个句子,好,那我就可以不等你说完,直接把这个预测的信息拿过来,预先进行翻译。

硅星人: 这样速度就更快了。

李磊: 没错,速度更快了,而且还节省了很多算力,我们就做了一个预测未来的工作。

为语言和科学研究去做生成式AI的算法

硅星人: 可以聊聊您现在整个的研究方向和您这个组在做的一些事情。

李磊: 用一句话来概括我们做的核心,就是为语言和科学研究去做生成式AI的算法。英文的话叫 Generative AI for Language and Science。

我们现在有四个我们认为非常非常重要的方向:

第一个是做这种语言通讯 (communication) 的技术,包括我刚才说的同传技术,也包括我们做的基于文本的翻译技术。最终的目标,我们希望能解决世界上大约80%-90%的语言沟通问题。

这大概需要覆盖多少语言呢?其实如果我们能够覆盖500到1000个语言,基本上就能解决世界上绝大部分人的交流问题了。当然,现在业界可能还处在覆盖100个语言的阶段。

硅星人: 所以像之前Gemini展示了一个很少见的语种的翻译,就让人觉得很厉害了。

李磊: 对,你要做到覆盖500个语言是很难的,1000个就更难。全世界一共有大约7000种语言,我们并不需要做到7000种,但如果我们能够解决1000种语言的翻译和理解问题,就能够帮助人们基本无障碍地交流。这是第一个我们觉得非常重要的方向。

第二个方向是智能体AI (Agentic AI)。我们要做的是用AI来进行推理,并且帮助人们完成一些任务,生成一些程序和代码,帮助人们完成一些任务。

第三块,我们还很关注生成式AI和LLM在安全、隐私和版权保护方面的问题,包括Safety和Security。我们正在做大模型上加水印的工作。我们在LLM的文本上做了水印,使得能够识别AI生成的文本,并且知道是哪个模型生成的。我们还能够去保护模型本身。假如说我要部署这个模型,部署之后别人可能会来“蒸馏”(distill)我的模型,我加上水印之后,就能够防止别人来蒸馏。

硅星人:或者至少能把成果归属弄清楚。

李磊:对,然后我们最近还有一些工作是去识别在预训练阶段,模型有没有使用某些特定的、受版权保护的数据,这个也很重要。还有就是保护用户的隐私,在训练过程中如何确保不使用任何与用户隐私相关的信息去训练。这是第三个方向。

硅星人:都很好啊。

李磊:最后一个方向是AI赋能科学研究 (AI for Science)。具体来说,AI for Science的范围也很大,我们的核心是用生成式AI的算法去做分子,包括小分子和蛋白质的设计。这是一个设计问题。

为什么做这个设计问题呢?我们认为分子是一个离散的结构。只要是离散结构,其实它和语言就非常非常像。我们说一句话,它是一个离散的序列。分子首先也可以表达成离散的序列,也可以表达成一个离散的图。有了这种离散结构之后,我们就可以用生成式AI的技术和模型,去做很好的生成。比如,我要设计一种能够加速某种化学反应的酶,如何去设计?我们最近就有一系列的工作,能够设计出三千种酶。一个模型能够针对这三千种酶,全部都去做设计。你只需要告诉它,我需要这三千种酶里面的哪一种,给它一些初始信息,它就能够生成对应的、符合这种酶功能的蛋白质序列。

硅星人: 我刚刚还想问为什么是“语言”和“AI赋能科学”,现在就说得通了。

李磊: 所以我们都是说,我们设计的是生成式人工智能的模型、算法和系统,用来处理离散结构的数据。语言是离散结构,分子也是离散结构,它们其实底层是相通的。

硅星人: 所以您给这个组或者您自己的研究兴趣,其实是基于对这个技术本质的理解,然后结合它擅长的地方去决定可能适合它的一些具体的、对行业和世界都很重要的话题。

李磊: 没错,完全准确。我们从两个角度去决定选择什么问题去做研究。一个是从基础技术角度,什么样的技术是比较通用,并且未来会非常有价值的,这是我们要去做的技术探索。另一个方面是从应用角度,什么样的应用是重要的,并且它会需要什么样的技术来处理。

工业界和学术界不是二元对立的

硅星人: 这很有意思。这让我想到在这篇论文里面,我看到你们除了讲新的技术路线,其实还有很大部分是讲它的效率提升,当把效率提到一定的程度以后,它甚至可以在端侧,在一些参数量很小的模型上去用。

李磊: 是的。

硅星人: 但我不觉得所有的学术研究者都会这样去想。

李磊: 对,没错。

硅星人: 所以这么看下来,你会鼓励大家做研究时候有点像是一个产品经理一样在做。

李磊: 没错。我要看看用户在怎么用。今天好的研究员,必须还得是好的产品经理了。

硅星人: 可能跟您过往的背景有关。

李磊: 没错,没错。

硅星人: 大家都说Connect the Dots,您可以简单讲讲您一路过来,在工业界和学术界的经历,以及这些经历如何影响您现在做的一些事情吗?

李磊: 我之前很长一段时间是在学术界,然后中间有大概七年在工业界工作。这些经历,我觉得对我现在做研究、选择哪些是重要的方向,是非常非常关键的。我个人认为,我们一定不能只做纯学术的研究,尤其是现在AI是一个以应用为导向的领域。我们通常称之为use-inspired research(应用启发式研究)。

什么叫应用启发式研究呢?就是我先去看应用场景。如果我要解决沟通的问题,那么它是在这种人与人的交互,有语音有文本的交互中,我要去看这里面关键的技术问题是什么。如果我要去做一个药物,设计一个药物,那我也要看这个设计药物的过程,针对什么疾病,需要什么样的药物,这些药物可以变成一个什么样的学术问题。把这些归纳出来之后,我们再去说我们做一些基础性的、通用性的一些方法,使得它在这些问题上,一旦基础方法有突破之后,在这些应用上面也会有非常大的突破,而且它能够比较通用,不仅仅解决一个非常具体的问题,而是可以通用到这一类的问题都能解决。

硅星人: 这两天咱俩都有跟很多还没毕业的学生交流。我觉得有个年轻人提得问题特别有意思,他说现在是不是已经变成工业界在决定研究什么,然后学术界去跟进?之前也有一些人会更极端地表达,说好像学术界在免费给工业界打工。比如GPT出来,我不用去做安全研究,会有人跟上去帮我做这个研究。这些您怎么看?因为您两边的经历都有。

李磊: 我认为学术界和工业界它不是对立的。大家是有一些竞争,但更多的是合作,同时又是在不断共同推动这个领域去进展。

从学术界来说,当然,对于做通用的、基础的这些研究,理解问题,做出重大的发现是最感兴趣的。但是,我们同时也要看到,这些技术研究出来,这些科学发现,新的算法发明出来,最终是要用到实际的应用当中去的。那怎么样用到应用当中去呢?最终归根到底还是要靠工业界,靠公司,靠这些初创企业,靠这些工程师和研究员,他们把这些东西放到技术、放到产品里面去,做出真正用户会来用的东西。

通过这个过程,它作为一个商业模式可以持续并且盈利。盈利之后,它还能够来反馈给学术界。反馈有两个方面:一个是说它反馈给学术界什么技术才是核心技术,需要去做突破的,那我们可以去更多地做研究;第二就是说它可能还会来资助学术界的研究,我们可以做一些前沿探索性的支持。

硅星人:不是二元论。

李磊:我举一个例子,就是说现在大家觉得,哦,ChatGPT都是OpenAI发明的,我们好像不需要学术界的研究,似乎工业界就可以了。其实不是。

我们要去追溯这个研究,它不是一下子出来的。就以神经网络为基础的语言模型的训练来说,它最早最早的一篇论文是98、99年一个研究员,当时他还是CMU的一个研究生,叫徐伟(后参与创办地平线机器人),也是我以前的老板,和他的导师Alex Waibel,他们最早发表了一篇论文,这篇论文现在还能读到。

他们是第一个把神经网络用过来去预测语言模型里面下一个词应该是什么,并且做了训练,展示了这个最早的想法。现在我们知道,我们可以把神经网络的规模做得非常非常大之后,它的预测能力会非常非常强。但这个起点的想法,最早的研究想法是这样出来的。

作为学术界其实非常适合去做一些非常前沿的探索,也许里面的有些想法它不一定成功,但也一些想法出来之后会发展成整个AI一个大的分支。

硅星人:今天看起来最聪明的头脑都在研究生成式AI,会不会太多的hype导致太多的注意力、太多的资源都集中在这里于是可能影响了AI的一些长期存在的、其他可能也有潜力的方向,甚至是除了AI以外的整个科学领域的其他一些领域。毕竟资源是有限的,你会有这种感觉吗?或者说一些反思?

李磊: 这个hype在任何一个时期它都会有。我想科学,你去看任何一个科学的领域,科学的分支,它的发展可能都是螺旋式上升的。AI在过去50年都是这样,螺旋式上升。这一轮,当然我们现在没有看到螺旋往下,它好像一直在上升。我认为适度的hype是有价值的。

我现在认为,科学研究你不能像做数学那样精确地规划好,说我只看只做这一个方向或者只做那个方向,我规划好。因为研究它的风险是比较高的,在没有出来之前,你并不知道这个方向会成功还是那个方向会成功。

所以我们应该像强化学习里面强调的探索 (exploration) 和利用 (exploitation) 这种概念一样,我应该做一些广泛的探索,但是当我有一定的发现之后,我又可以缩小范围 (narrow down),说针对某一些非常有前景 (promising) 的方向,可以收敛,更多地集中资源去做。

当然,集中也不意味着其他的方向我就不做了。这种就是学术界和工业界可以去配合,可以去合作。工业界可以说,我在已验证的方法上证明了这个方向是有效的 。那么它可以集中资源,现在就是大语言模型,那显然有效,我把规模 (scaling) 提上去,数据提上去,计算提上去,模型规模提上去,我一定是会有效的。好,那我集中投入资源去做,这是可以的。

那么学术界它其实可以说,我不仅仅看现在已经证明有效的,我还可以去探索一些其他的,比如说我可以看多智能体 (Multi-agent),我不仅仅有一个AI模型,我可以有很多的AI模型,大家可以一起来协作,大家相互竞争或者相互合作来解决一些复杂的问题。

硅星人:今天一切变化都很快发生,不光是技术在融合。其实刚才我们聊到的一个很重要的话题,就是可能工业界跟学术界又在融合,这里面的关系其实也是在一直变化。您自己也经历过。其中体现出来一个很重要的形式,就是工业界尝试去办一些类似实验室形式的东西,然后去尝试做本是学术界在做的一些前沿的突破。你自己观察说这些接下来的一些新的组织形态会是什么样子?会不会工业界不满足于说反馈给学术界,而是自己做了闭环?

李磊: 工业界的这种研究实验室 (research lab) 应该以什么样的形式组织?

我个人认为这应该是一个动态变化的过程,不应该以一个固定的模式,而应该审时度势,与时俱进。就是你要看当前这个行业,以及从具体的公司、具体的业务的需求,以及公司拥有的人才团队出发,去看什么样的组织形式最好。

大家当然知道贝尔实验室 (Bell Labs) 他们这种工业研究实验室非常非常成功,他们也有划时代的发现,都有诺奖级别的发现,当然非常非常好。但是他们这种组织形式是不是一定适合现在的,现在最新的这种新时代的每一个公司都可以用这种形式呢?其实不是。那包括贝尔实验室之后也有各种公司它尝试不同的形态嘛,包括像微软研究院 (Microsoft Research),Google的形式,Google它也有不同的形式,Google Research,后来叫Google Brain,现在叫DeepMind,这些也有不同的形式。对,然后包括Meta,他们有这种Meta Research, FAIR,他们现在又有GenAI的这种组织形式。那这种形式当然是不一样的。我想不能说就是套一个公式说,哎,这个就一定是最好的,所以我所有公司在不管什么时候我都用这种,那可能是没有的。可能只能说我们要去借鉴。

但我觉得对于公司来说,应该去找适合公司发展的、并且适合这个公司团队以及适合公司业务需求的这种组织形式。那在一定情况下可能需要做一些开放式的前沿探索,那如果有这样的机制,它可能会产生像DeepMind的AlphaFold这样划时代的、诺奖级的工作,这个当然是非常非常好,对吧?但是你也不能说我所有的资源都投入去做这种,那公司就不盈利了,对吧?

所以我想最后可能就是说,他们需要更多地去做那种目标导向的、非常明确的、并且集中资源干大事的这种研究。

(来源:新浪科技)