专访AirPods团队:一只小小的耳机,如何学会追踪50种运动?

音乐的出口

身体的入口

带心率监测的耳机,并非苹果首创。

过去十年,Jabra、Sennheiser、Beats 都在这条赛道上尝试,但这些锦上添花的功能都让没能打动 Nick Harris-Fry,作为资深跑者、Tom’s Guide 的健身编辑,他几乎试遍了所有品牌的心率耳机,结论却始终一致:没有一副耳机能与胸带的精度相提并论。

胸带,那条勒在胸口略显不便的装置,至今仍是普通消费者能买到的最可靠的心率监测设备。

直到 AirPods Pro 3 的出现。

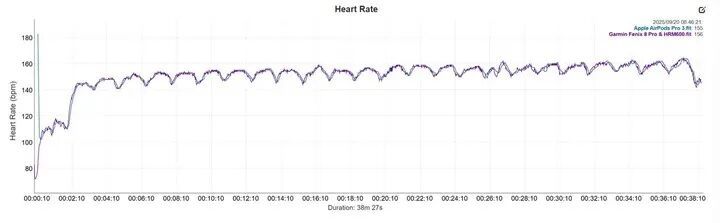

Nick Harris-Fry 以 Garmin HRM600 胸带(电信号级精度)作为对照,结果发现 AirPods Pro 3 的心率曲线几乎与胸带重合,尤其在稳态跑与间歇跑这种对精度要求极高的场景下,两条曲线如同镜像般贴合。

更令人惊讶的是,它能在播放音乐的同时,感知你的心跳频率、判断步伐节奏,并实时识别超过 50 种运动类型。

AirPods Pro 3 是如何实现的?

为了找到答案,爱范儿专访了苹果感知与连接副总裁 Ron Huang 与健康感知总监 Steve Waydo,在这场对话中,我们试图理解的不仅是一项新技术的工作原理,更是苹果如何思考「身体」这个终极界面。

耳道,也许比手腕更懂你

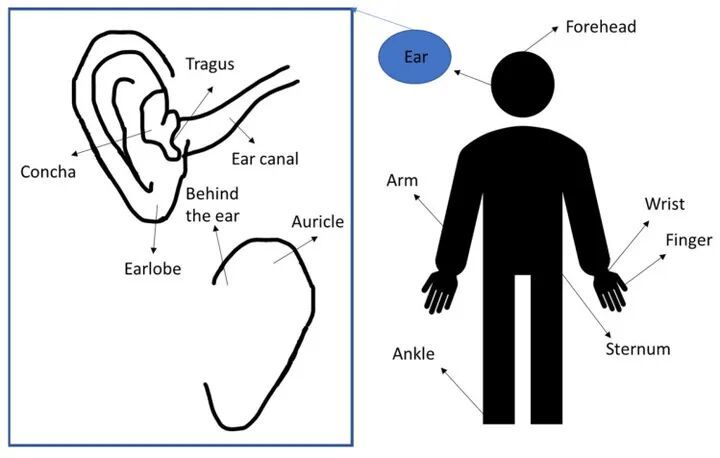

从生理结构上看,耳道是一块天然的传感「黄金地带」。它靠近颞浅动脉,血流灌注稳定,又被外耳包裹,几乎没有外界光线干扰。

这些特性,让耳道成为比手腕更理想的生理信号采集点。

美国一篇论文《可穿戴光电容积脉搏波分析原理及其在生理监测中的应用》[1]明确指出:

耳道 PPG(光电容积描记)信号在血管分布、抗运动干扰和环境光抑制方面,优于腕部与指端。

相比之下,手腕是一个充满变数的测量场域。肌肉频繁运动,摆臂幅度剧烈,汗液、毛发乃至肤色都会干扰光信号的传播。

苹果健康感知总监 Steve Waydo 在实验中反复验证了这一点:在力量训练、划船等需要握紧器械的场景下,腕部设备往往难以稳定测心率,而耳机测到的血流信号更加连贯。

在耳道这个暗箱式环境中,AirPods Pro 3 采用了红外光 PPG(IR PPG) 方案——有别于市面上大多数设备使用的绿色 LED 光源。

Steve Waydo 解释说,红外光的能耗更低,也避免了「耳朵冒绿光」的尴尬。

更重要的考量是,红外波长更深,穿透力更强,能够深入血管密集的耳道组织,捕捉到更干净、更稳定的脉冲信号。

AirPods Pro 3 的传感器每秒脉冲约 250–256 次红外光,同时结合 IMU(加速度计与陀螺仪) 数据,用来消除运动伪影——比如跑步时脚步触地带来的节奏性震动,或者转头时产生的加速度变化。

这种光学信号与动态数据融合的算法,是 AirPods Pro 3 能在运动中保持心率精度的关键。它不是单一传感器的胜利,而是多模态数据协同的结果。

苹果感知与连接副总裁 Ron Huang 补充说:

当用户同时佩戴 Apple Watch 和 AirPods Pro 3 时,系统会在最近 5 分钟的信号里滚动比较,并自动选择更可靠的来源。

例如在力量训练中,手部抓握动作较多,腕部设备的数据会受到干扰,系统就会更多优先选择来自耳道的心率信号。

从这个角度看,Apple Watch 和 AirPods Pro 并不是为了相互取代,而是为了在不同场景下互为补充,共同在为同一个身体建立更完整更真实的数字镜像。

十年算法的缩小成果

Waydo 的团队从 Apple Watch 诞生之初就开始积累算法。那套神经网络原本是为手腕设计的,针对的是腕部血管的光学特性、手臂摆动的运动模式、皮肤组织的光散射规律。

但令人意外的是,这十年的积累并未因平台切换而作废——它们成为了 AirPods 心率传感器开发的基础。

由于耳机的空间极为有限,AirPods Pro 3 使用的是 Apple Watch 心率算法的「小型化版本」。

他们从原型耳机中采集到的大量数据,进一步微调模型,使其在极端条件下也能准确追踪心率。测试包括不同肤色、耳型、温湿度和运动强度,甚至在寒冷气候中仍保持稳定。

「贴合度」是在采访中被反复提到的一个关键词,它不仅关乎声学体验——主动降噪的效果、空间音频的沉浸感,更直接决定了生理数据的准确性。

当耳塞贴合良好时,双耳协同的心率读数非常精准。

Steve Waydo 说。

这也是苹果在 AirPods Pro 3 上重新设计入耳结构、优化硅胶耳塞形状、升级自适应调音算法的隐性原因——那些看似为了声音的改进,同时也在为生理监测铺路。

像大语言模型那样:如何让耳机理解 50 种动作?

准确的心率监测只是起点。

苹果的目标是:让 AirPods Prio 具备与 Apple Watch 相当的运动体验——不仅要知道你的心跳快慢,还要理解你正在做什么运动,消耗了多少卡路里,跑了多远的距离。

这意味着,苹果必须榨干「所能利用的每一个传感器。」

AirPods Pro 3 在感知系统上其实是像个「小生态系统」。在耳机侧,它部署了加速度计、陀螺仪和心率传感器,在 iPhone 侧,则贡献了 GPS 与气压计。这些传感器产生的数据流,需要被实时整合、解析、转化为有意义的运动指标。

Ron Huang 提到,Apple Watch 上已积累了大量动作信号的经验,比如跑步时手臂的摆动、划船机训练的动作模式等。把这套能力迁移到 AirPods 后,需要把原来针对手腕的动作观测「翻译」为对头部运动的观测。

为此,团队借鉴了大语言模型(LLM)的训练思路——通过海量数据学习通用的「动作语法」,而非为每种运动硬编码规则。

他们基于 Apple Heart and Movement Study(心脏与运动研究)中约 5000 万小时的真实运动数据,训练了一个全新的动作基础模型(Motion Foundation Model)。

那是一项苹果几年前面向公众发起的开放研究,参与者自愿捐献来自 Apple Watch 与 iPhone 的运动数据。

它本质上是一个回归模型,能理解你在做哪些活动、是否在对抗阻力、动用大肌群还是小肌群、运动平面与身体姿态等。

为了确保算法能覆盖普拉提、HIIT、椭圆机等不同类型的锻炼,苹果邀请了不同体能与技能水平的参与者进行测试与校准。

在实验室中:在他们采用了被认为是「黄金标准」的方式——佩戴氧气面罩,用代谢面罩(Metabolic Cart)观测真实氧气交换率,以验证卡路里模型的准确性。

在步数与距离的追踪上,团队开发了全新的行人运动神经网络。他们邀请数百人进入生物力学实验室,使用标定跑步机记录距离,在鞋底放置压力传感器标记落脚与离地时刻,并用摄像机捕捉完整步态。

最终,他们得以在 AirPods 上「一次性推出超过 50 种运动类型」的追踪能力,而这在 Apple Watch 时代花了几年才达成。

从声学到身体:技术的终极归宿

作为一种时刻贴近身体的设备,AirPods 天然地处于一个微妙的位置:它既面向外部世界,放大声音、过滤噪音、重构空间,又面向内在自我,感知呼吸、追踪脉搏。

当一个声学器件开始理解心跳的起伏、步伐的韵律、身体的语言,它就不再仅仅是一个输出设备,而是一个双向的感知界面。

从「听世界的声音」到「听身体的声音」,这条路径延续了苹果一贯的产品哲学——技术最终要回归人的感知。

耳机曾经只是音乐的出口,内容的播放器。而现在,它正成为身体的入口,自我认知的传感器。当技术学会倾听身体,它才真正学会了倾听人。

(来源:新浪科技)