刚刚,摩尔线程宣布开源!代码量暴降90%

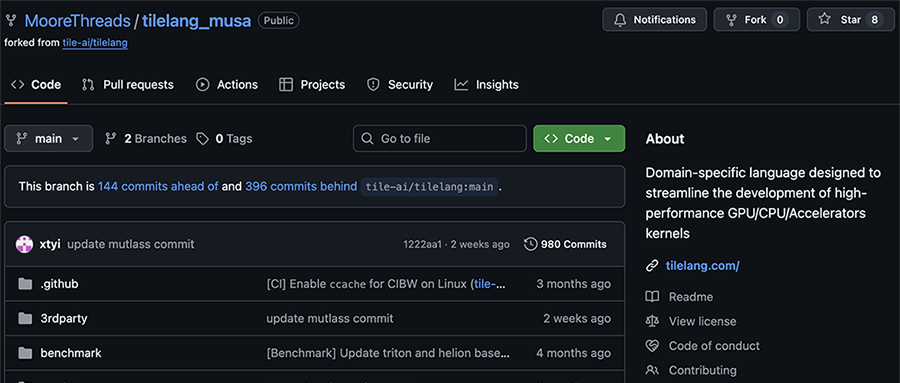

芯东西2月10日报道,今天,摩尔线程宣布近日开源TileLang-MUSA项目,实现对TileLang编程语言的完整支持,旨在充分释放全功能GPU的性能潜力,大幅降低国产GPU开发门槛。

此前DeepSeek-V3大模型的研发已采用TileLang进行算子快速原型设计与性能验证,证明了其在大规模模型训练中的实战价值。

TileLang_MUSA项目已在摩尔线程多代全功能GPU上完成功能验证与特性开发,验证了“高层语言+国产GPU”技术路线的可行性。

01.

重新定义GPU算子编程,

“零门槛”实现算子迁移

TileLang是一款基于张量分块(Tiling)抽象的高性能AI算子编程语言,属于领域特定语言(DSL),采用声明式语法与类Python前端,使开发者能以接近数学公式的形式描述计算意图,并由编译器自动完成循环优化、内存调度与代码生成,在保持底层性能的同时,大幅降低GPU及异构计算平台的编程复杂度。

在实际应用中,TileLang通过高级抽象降低开发门槛,具备跨平台能力,实现“一次编写、多架构运行”,编译器自动执行Layout推导、线程映射、Warp特化、流水线排布、内存优化等复杂优化,在保障性能的同时提升GPU计算的开发效率,已广泛应用于AI与机器学习、科学计算等领域。

TileLang-MUSA项目提供了一种介于底层汇编与高层DSL之间的“中间层”抽象,

在保留硬件控制力的同时,显著降低编程复杂度。

该项目硬件兼容性良好,已在摩尔线程多代全功能GPU上完成功能验证与打通,包括训推一体全功能智算卡MTT S5000和MTT S4000。

团队还实现了TileLang高层语义到摩尔线程GPU底层MUSA架构的精准映射。

Tensor Core加速:编译器能够自动调用MUSA的MMA(矩阵乘累加)指令,充分发挥硬件张量核心的峰值计算能力;

Tile-Level Pipeline:自动处理从全局内存(Global Memory)到共享内存(Shared Memory)再到寄存器(Registers)的多级数据搬运,利用MUSA异步拷贝指令掩盖访存延迟;

Warp级并行优化:完整支持Warp Specialization特性。

目前,基于MUSA架构的TileLang原生算子单元测试覆盖率已超过80%,为大规模应用提供了可靠保障。

在完成环境配置后,开发者可保留原有的import tilelang习惯,通过Cython编译后端直接在MUSA环境中运行TileLang代码。

02.

实测兼顾开发效率与运行性能,

代码量减少约90%

在实际算子开发实践中,TileLang-MUSA实现了让开发者“写得快”且“跑得快”。

以大语言模型中重要的FlashAttention-3和GEMM(通用矩阵乘)算子为例,在摩尔线程MTT S5000上的测试结果显示:

(1)开发效率倍增:相较手写MUSA C++代码,使用TileLang-MUSA的代码量减少了约90%,且代码逻辑更加清晰,极大降低了开发与维护成本。

(2)性能媲美手写:得益于编译器优化,生成的算子性能在典型配置下,Gemm最高可达手写优化版本的95%,FlashAttention-3可达手写优化版本的85%。

(3)自动化调优:借助TileLang-MUSA的Auto-tuning机制,开发者可在MUSA架构的全功能GPU上快速搜索最优的分块策略(Tile Size)和流水线级数,轻松超越未经深度优化的基准实现。

TileLang-MUSA的推出,使TileLang用户能近乎零成本地将算子逻辑迁移至摩尔线程GPU,还为不熟悉MUSA指令集的AI工程师提供了高层次的开发入口,并通过支持FlashAttention等关键算子的高效开发,加速大语言模型等前沿AI应用在国产算力平台上的部署与落地。

03.

结语:计划打造基于MUSA的

深度学习统一平台

TileLang-MUSA的开源是摩尔线程构建国产算力生态的关键一步,摩尔线程计划持续推进平台与生态建设,致力于打造一个覆盖从单算子到完整大模型的国产算力统一加速平台。

其计划包括深度集成SGLang等主流AI框架,实现Transformer、MoE等复杂模型架构的跨算子调度与全局优化,完善调试和性能分析工具链,以及通过性能优化,开发更多MUSA架构定制扩展,使生成代码性能稳定达到手写优化版本的90%以上。

这将为构建一个开放、易用的国产算力开发生态提供工具支撑。

(来源:新浪科技)