腾讯混元推出0.3B端侧模型,内存占用仅600MB

IT之家 2 月 10 日消息,今日腾讯混元宣布,基于首个产业级 2Bit 端侧量化方案,正式推出一款面向消费级硬件场景的“极小”模型 HY-1.8B-2Bit,等效参数量仅有 0.3B,内存占用仅 600MB,比常用的一些手机应用还小。

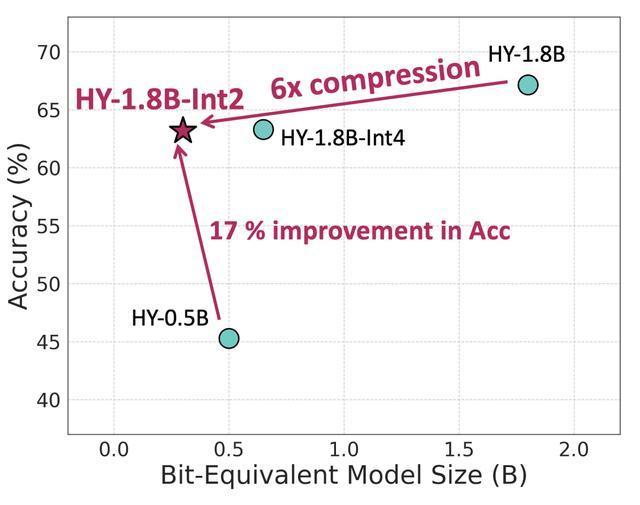

据介绍,通过对此前混元的小尺寸语言模型 ——HY-1.8B-Instruct 进行 2 比特量化感知训练(QAT)产出,这一模型对比原始精度模型等效参数量降低了 6 倍,并且在沿用原模型全思考能力同时,在真实端侧设备上对比原始精度模型生成速度提升 2—3 倍,可大幅提升使用体验。

IT之家附官方详细介绍如下:

随着大语言模型普及,如何将模型在比如手机、耳机或者智能家居设备应用,成为业界难题,尤其不少应用对模型的离线部署、私密性等都有更高的需求,这就需要更多能够在端侧运行的又小又强的模型。

端侧部署的展开,本质上是一条在“小而精,快而准”的艰难探索之路,我们既需要模型足够聪明,能应对千变万化的真实需求,又必须将它约束在极其有限的硬件资源内部署并快速推理,这就好像在给模型进行“减脂增肌,减重提质”。

此次腾讯混元推出 HY-1.8B-2Bit 模型,可以在边缘设备上无压力部署。这也是首个在实现 2bit 产业级量化的端侧模型实践。

HY-1.8B 原始精度模型

HY-1.8B-2Bit 模型

比特(Bit)是计算机存储的最小单位,1 比特能表示 2 种状态(0 或 1),2 比特能表示 4 种状态,依此类推,一般模型的精度有 2 比特、4 比特、8 比特、32 比特等表示方法,数值越大模型的精度更高,所占的内存就越大。

虽然 2 比特量化的精度损失较大,但通过 QAT 和先进的量化策略,已经能让 2 比特模型接近全精度模型的性能。在模型能力方面,对比 4 比特 PTQ 模型版本数学、代码、科学等指标上表现相当,实现了“小而强”的设计目标。

此外,HY-1.8B-2Bit 模型还沿用了 Hunyuan-1.8B-Instruct 的全思考能力,用户可以灵活使用,为简单的查询提供了简洁的思维链,为复杂的任务提供了详细长思维链,用户可以根据其应用的复杂性和资源限制灵活地选择这两种模式。

技术上,量化作为大模型部署上线不可或缺的一环,肩负了降低部署成本与保精度的使命,大部分情况下对于 int4、int8、fp8 的压缩精度要求,采用 PTQ 量化策略即可实现几乎无损,但随着原始模型大小的缩小、压缩 bit 数的进一步降低,PTQ 带来的量化损失是巨大的。因此,对于原始模型大小只有 1.8B,量化 bit 数只有 2bit 的 HY-1.8B-2Bit,混元团队采用了量化感知训练策略,这显著提升了量化后模型的性能。

腾讯混元还通过数据优化、弹性拉伸量化以及训练策略创新三个方法来最大限度的提升 HY-1.8B-2Bit 的全科能力。

部署方面,腾讯混元提供了 HY-1.8B-2Bit 的 gguf-int2 格式的模型权重与 bf16 伪量化权重,对比原始精度模型,HY-1.8B-2Bit 实际模型大小直降 6 倍,仅有 300MB,能够灵活用于端侧设备上。该模型也已在 Arm 等计算平台上完成适配,可部署于启用 Arm SME2 技术的移动设备上,并实现高效运行。

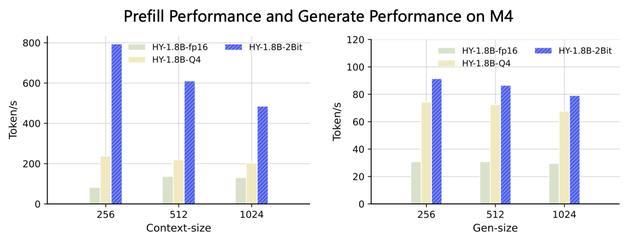

在 MacBook M4 芯片上,HY-1.8B-2Bit 固定了线程数为 2 测试了不同窗口大小下的首字时延和生成速度,模型选定 fp16、Q4、HY-1.8B-2Bit 三种 gguf 格式作为对比,首字时延在 1024 输入内能够保持 3~8 倍的加速,生成速度上常用窗口下对比原始模型精度,HY-1.8B-2Bit 能够实现至少 2 倍稳定加速。

在天玑 9500 上同样进行了测试,对比 HY-1.8B-Q4 格式首字时延能够加速 1.5~2 倍,生成速度加速约 1.5 倍。

为在边缘设备上实现大语言模型的灵活部署,HY-1.8B-2Bit 采用了极低比特量化技术,在保持与 INT4-PTQ 方法相当模型性能的同时,实现了在端侧设备上的高效稳定推理。

当前,HY-1.8B-2Bit 的能力仍受限于监督微调(SFT)的训练流程,以及基础模型本身的性能与抗压能力。针对这一问题,混元团队未来将重点转向强化学习与模型蒸馏等技术路径,以期进一步缩小低比特量化模型与全精度模型之间的能力差距,从而为边缘设备上的大语言模型部署开拓更广阔的应用前景。

(来源:新浪科技)