卷起来了,科技巨头齐发AI芯片,买GPU不如自研香

让英伟达躺着赚钱?其他科技巨头们不干了!

这几天,谷歌、英特尔、Meta等科技巨头集体官宣新款AI芯片。其中既有英特尔Gaudi 3这样直接硬刚英伟达H200的“性能怪兽”,也有谷歌Axion这种主打高效全能的“性能钢炮”。

而这些芯片都有同一个特性,都是为了AI模型服务。

这场AI军备竞赛,最终还是卷向了硬件。

主打性价比,英特尔硬刚英伟达

当地时间4月9日,在Intel Vision 2024会议上,英特尔CEO帕特·基辛格(Pat Gelsinger)推出了最新AI芯片Gaudi3,并现场与DJ来了一场蹦迪。

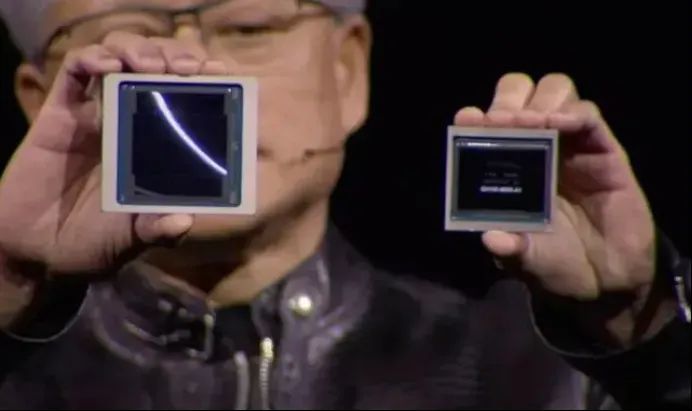

为什么基辛格如此高兴?让我们看看这款芯片的参数——芯片模型训练层面,Gaudi3比英伟达H100快40%;推理层面Gaudi 3比英伟达H100快50%。

与现在最强的英伟达H200相比,Gaudi 3的推理速度依然保持优势。虽然基辛格没有在现场给出直接的数据,但他表示Gaudi 3在某些领域的性能甚至会更好。

英伟达H200的性能毋庸置疑,它具备460万亿次的浮点运算能力,并且有丰富的CUDA生态。相比之下,Gaudi 3其实并没有太大优势,更别说对标B200这种最强大的芯片。

但Gaudi 3的特点就是“又好用又便宜”。

目前,H100的售价约在每台2.5万至4万美元之间。那么作为升级款的H200,其上市后必然不会低于这个价格。

同理,英伟达的Backwell芯片预计售价为3-4万美元,也符合英伟达目前的“身价”。这对于急需AI芯片的客户来说,购入H100已经是一笔不小的开销。

成本高是一回事,买不到货更客户们头疼。

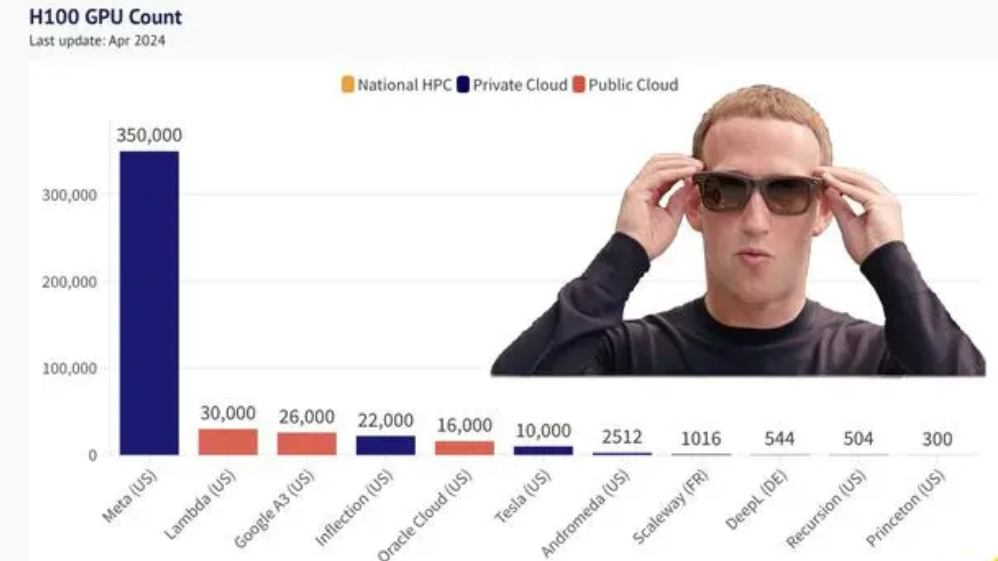

最近,X用户“The Technology Brother”发布了一张图片,数据显示Meta公司囤积了全球最多的 H100 GPU,数量达到惊人的35万块,剩下的公司从3万块到300块不等。

根据GPU Utils网站在2023年的测算,H100缺口高达43万张。如此大的供应缺口,一些小公司只能等着订单排队。

H100芯片卖给谁,基本是英伟达CEO黄仁勋说了算。目前只有大客户还有CoreWeave这种英伟达亲自投资的公司才有优先购买权,亚马逊、微软等竞争对手只能限量供应。

更不要说,国内AI公司只能购买到A800这样的阉割版产品。在AI算力竞赛面前,手握高端GPU就是手握优势。

当然,限制H100并不全是英伟达的问题,台积电的产能也要背很大的锅。

总的来说,Gaudi 3不仅性能不输H100,英特尔又有自己的代工能力,难怪基辛格有硬刚英伟达的信心。

当客户变成对手

除了多了一位竞争对手外,英伟达的客户们也选择自研芯片的方式来减少对高端GPU的依赖。

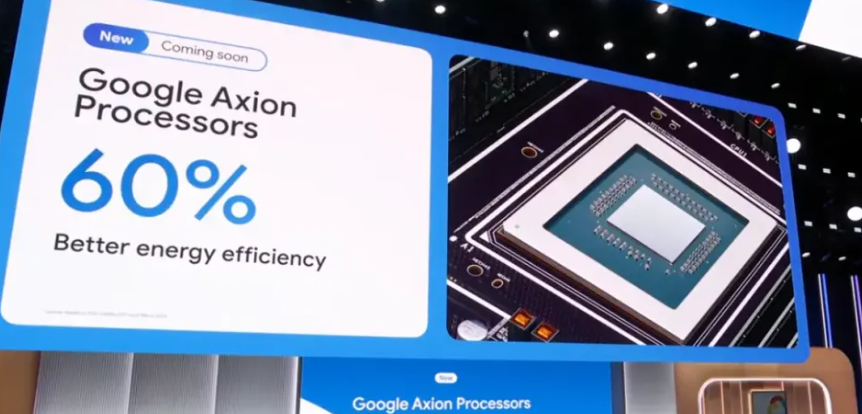

在英特尔公布Gaudi3后,谷歌在Next大会上宣布推出自研首款基于Arm的CPU——Axion。

据悉这款CPU处理器Axion,将提供比英特尔CPU更好的性能和能源的效率,并且比目前基于Arm的最快通用芯片,性能还要高出30%。

虽然对标着英特尔的CPU,但谷歌这块芯片实际是为了训练复杂的AI模型做准备。和Gaudi 3一样,Axion主打一个“性价比”,靠着自己出色的AI能力,为包括Google地球引擎和YouTube广告平台在内的多项服务提供算力。

同样是自研芯片项目,谷歌也对自家超算平台进行了升级,推出了TPU v5p。

这是一个类似于英伟达GPU的替代品产品,用于AI加速任务。在自家最先进的AI模型Gemini和开放AI模型Gemma支持下,TPU v5p将支持更大、更苛刻的模型。

有着CPU与TPU的双重加持,谷歌的自研芯片项目越来越丰富。

无独有偶,Meta也赶在了今天推出了新一代训练和推理加速器MTIA 。

早在去年5月,Meta公布了 7nm工艺的MTIA v1,专注于向数据中心服务。

而此次推出的新款 MTIA 芯片,采用5nm工艺,使用更大的物理设计、拥有更多的处理核心,功耗从25W提升到了90W,时钟频率也从800MHz提高到了 1.35GHz,整体性能提高了3倍。

Meta表示,目前已经在16个数据中心使用新款 MTIA芯片,这就意味着Meta在自研芯片上费了不小的精力。

除了近期陆续公布新芯片的三家巨头以外,算上亚马逊AWS推出的Trainium和Inferentia两个系列AI芯片,以及微软在自家技术大会期间发布的用于云端AI训练和推理芯片Maia 100,目前绝大多数科技公司们都有了自研AI芯片项目。

结语

AI算力的军备竞赛,正在愈演愈烈。每家科技公司都已经预料到AI模型的规模会迅速扩大。

然而从目前现状来看,英伟达GPU依然牢牢掌握着全球算力资源,并且通过最新的AI芯片不断稳固当前的商业模式。

但GPU的价格摆在那里,即使是财大气粗的科技巨头,也要计算性能和成本效益。

既然自己有能力在硬件上做出性能相当且最合适自己的AI芯片,那么谁不想与英伟达全面一较高下呢?

不过在缺少生态和产量的前提下,英伟达的GPU依然是科技公司的首选。就看台积电和英特尔在代工这一环节,能不能给点力了。

本文作者:jh

(来源:新浪科技)